大家好,我是枫夜求索阁。昨天,DeepSeek开源了Engram,今天朋友圈和公众号都是这个的相关话题。我也抽空去GitHub看了这个论文。为了更快地获取关键要点,使用了AI工具协助理解。当然,本文的重点在于探讨Engram与RAG有什么区别,分别有什么作用。请看正文!!!

开源地址

什么是Engram?

DeepSeek 推出的 Engram 项目旨在为大型语言模型引入一种名为条件记忆的新型稀疏性架构,以解决传统模型在知识检索能力上的局限。通过将经典的 N-gram 嵌入与现代 Transformer 结合,该技术实现了极低开销的常数级查找,让模型能高效提取静态知识。研究表明,这种设计能减轻底层网络的计算负担,使模型在保持等效计算量与参数量的同时,显著提升在数学、代码及逻辑推理任务中的表现。此外,该系统支持将庞大的记忆表格离线存储至主机内存,在大幅扩展模型容量的同时,依然维持着极高的推理效率。架构图如下图:

什么是RAG

检索增强生成 (Retrieval-Augmented Generation,简称 RAG) 是一种将大型语言模型(LLM)的逻辑推理能力与外部、动态知识库相结合的混合人工智能架构。通俗地说,如果把普通的大模型比作一个凭记忆答题的考生,那么 RAG 就像是为这位考生提供了一本可以随时翻阅的“参考百科全书”,让 AI 从“闭卷考试”转向“开卷考试”。

两者有什么区别?

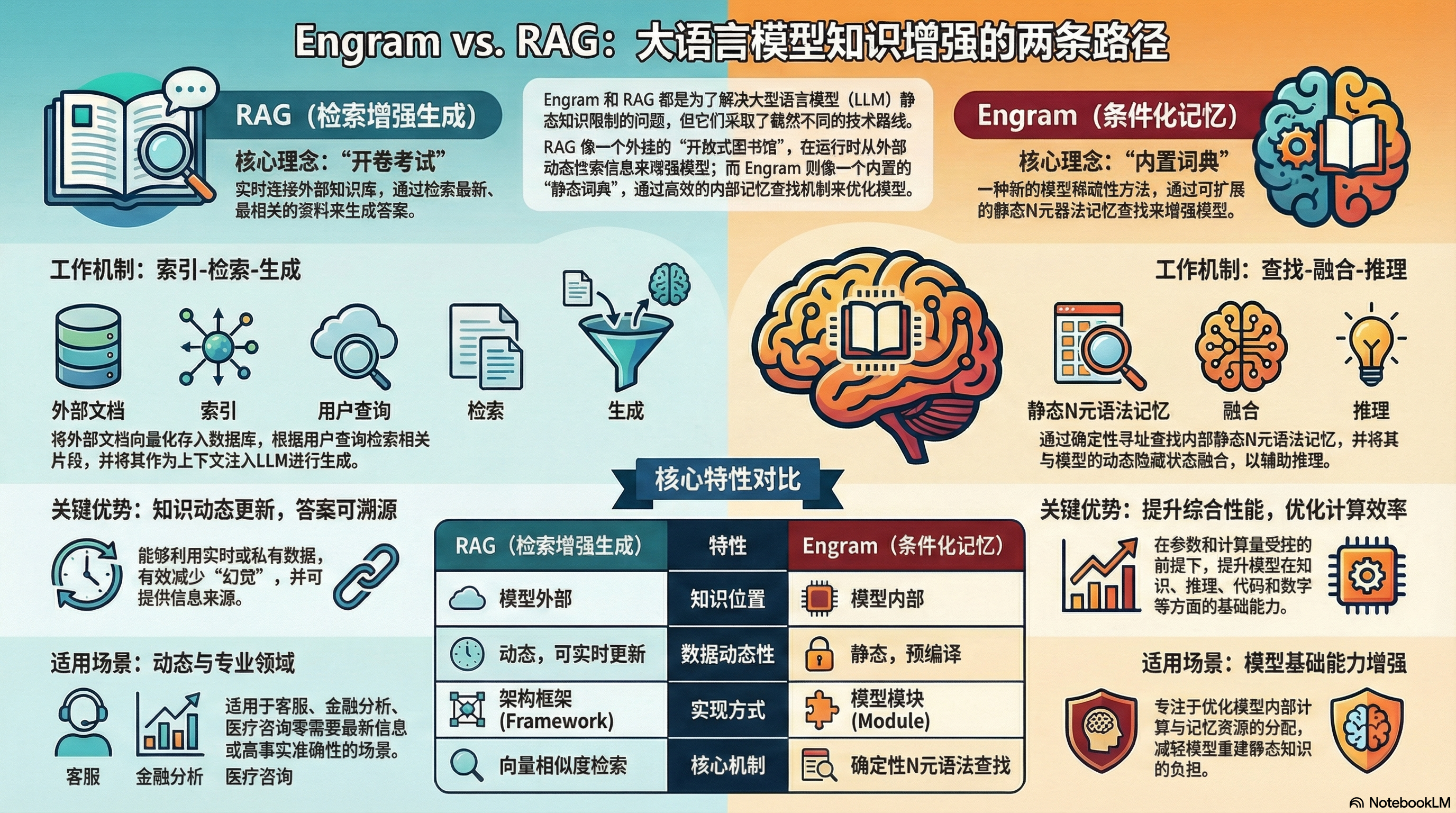

Engram 和 RAG(检索增强生成)虽然都是为了增强大语言模型(LLM)处理知识的能力,但它们在技术层级、实现机制和核心目标上有显著区别。

1. 技术性质与集成层级

- Engram 是一种架构级的“条件记忆”模块: 它被视为 Transformer 模型的一种原生原语,是模型结构的一部分,与混合专家模型(MoE)互补。它通过检索静态的 $N$-gram 记忆并将其与动态隐藏状态融合来增强模型主干。

- RAG 是一种系统级的“外接知识”管道: 它是一个独立的框架,在模型生成响应之前,先从外部数据源(如向量数据库、API 或文档库)提取相关信息。RAG 更多地被视为一种“开卷考试”的模式,将模型作为处理器,而将知识留在外部。

2. 检索机制与复杂度

- Engram 实现 $\mathcal{O}(1)$ 复杂度的快速查找: 它将现代化的 $N$-gram 嵌入技术与确定性寻址(Deterministic Addressing)相结合,实现了极速的知识检索。

- RAG 依赖语义搜索和向量比对: RAG 通常使用嵌入模型(Embedding Model)将查询和文档转换为向量,并通过近似最近邻(ANN)搜索或余弦相似度来寻找匹配项。这种检索过程通常比 Engram 的查表式查找更复杂且耗时。

3. 处理的数据类型与存储方式

- Engram 专注于“静态模式”: 它主要处理词组、语法或代码片段等 $N$-gram 模式,并将海量的嵌入表存储在主机内存中,推理开销极小。

- RAG 专注于“事实性文档”: RAG 检索的是具体的文档片段、事实、客户记录或最新的新闻等。这些数据存储在外部的向量数据库(如 Pinecone、Milvus)中。

4. 核心目标与效用

- Engram 旨在提升效率与深度: 它通过接管模型前几层的“静态模式重构”工作,让模型能够将更多的计算资源(深度)留给复杂的逻辑推理任务。

- RAG 旨在解决幻觉与时效性: 它的首要目标是降低模型的“幻觉”率,为模型提供最新的、私有化的参考资料,确保回答有据可依。

类比理解:

- Engram 就像是你的 “语感和直觉“。当你看到一句话的开头,能瞬间反应出接下来的固定搭配,不需要思考(

查找),这让你能腾出大脑精力去思考更深层的逻辑。

- RAG 就像是你手边的“百科全书”。当你被问到一个不熟悉的知识点时,你会停下来翻书查资料(外部检索),然后根据查到的内容组织语言回答。

路径对比图

下图是比较详细的对比图:

小结

现在AI越来越厉害了,可以预期的事情就是未来我们会有更多更厉害的AI工具来辅助我们。怎么学会使用AI重构我们的工作流程和生活流程,是当下我们最大的命题!!!