Hello,大家好,我是枫夜求索阁。目前很多平台都提供研究的功能。目前在字节的豆包平台,小小尝试了一下,没想到产出的作品质量还很不错,基本面面俱到。当然,这个主要也是通过查询网上的资料,然后做总结。作为个人,其实也是可以做到的,但是会花费很多时间在查询资料,并且需要进行总结。有了这个AI的研究功能,给我们节省了很多时间和精力。当然,我们也需要进行一定的鉴别,不然很容易被误导。以下文章为字节豆包的研究功能所产出的。

一、引言:本地文生图模型的兴起与发展

2025 年 12 月,文生图技术正处于爆发式发展阶段,生成速度从分钟级缩短到秒级,支持分辨率高达 4K 甚至 8K。随着技术的成熟和硬件成本的下降,越来越多的用户开始关注在本地 Windows 系统上部署文生图模型,以获得更高的隐私性、更低的使用成本和更强的创作自主性。

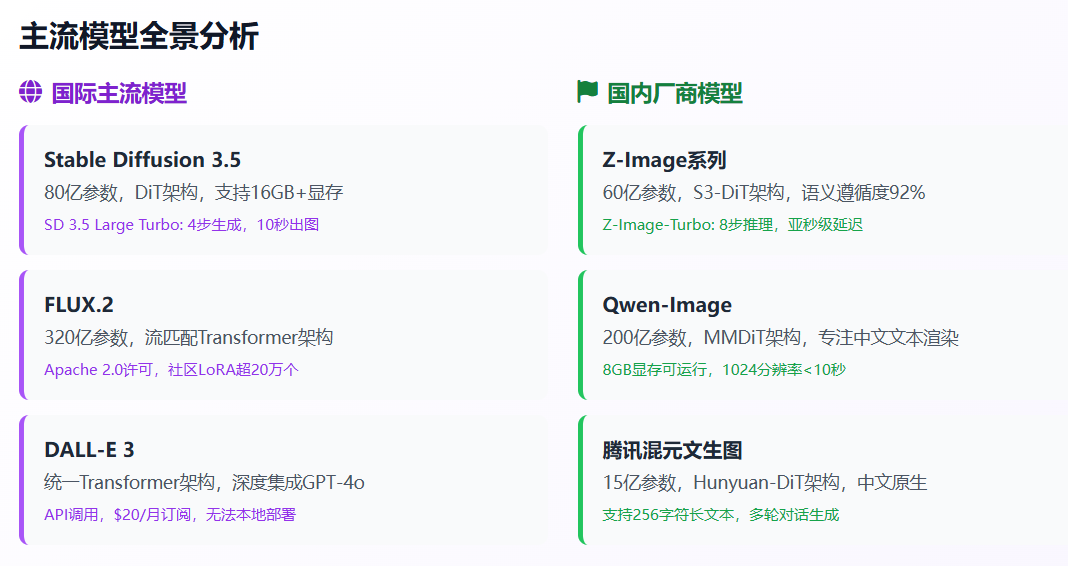

当前文生图模型呈现出开源主导创新的格局,Stable Diffusion 生态系统不断壮大,同时国内厂商也在积极布局,推出了如 Z-Image、Qwen-Image、腾讯混元等具有自主知识产权的模型。这些模型在技术架构、生成效果、硬件要求等方面各有特色,为不同需求的用户提供了丰富的选择。

对于商业用户而言,特别是需要进行竞品分析的企业,本地部署文生图模型具有独特优势:数据安全可控,避免了敏感信息上传云端的风险;成本效益高,一次性硬件投入后可无限生成;创作自由度大,不受平台限制,可生成各种风格的图片用于对比分析。

本文将全面梳理当前流行的本地 Windows 文生图模型,深入分析各模型的技术特色和生成效果,详细介绍部署和使用方法,并推荐适合的可视化界面工具,为您的竞品分析工作提供完整的技术解决方案。

二、主流本地 Windows 文生图模型全景分析

2.1 国际主流模型

Stable Diffusion 系列作为开源文生图模型的代表,在 2025 年已经发展到 3.5 版本,包含多个变体以适应不同的硬件环境和使用场景。SD 3.5 Large 拥有 80 亿参数,采用全新的 DiT 架构,支持 16GB 以上显存;SD 3.5 Large Turbo 是其蒸馏优化版本,通过时间步蒸馏技术将生成步骤压缩至 4 步,单张图像生成时间缩短至 10 秒,推荐 8GB 以上显存即可运行;SD 3.5 Medium 将于 2025 年 10 月 29 日发布,拥有 25 亿参数,采用改进的 MMDiT-X 架构,可在消费级硬件上 "开箱即用"。

FLUX 系列由德国 Black Forest Labs(前 Stability 成员创办)开发,FLUX.2 于 2025 年 11 月发布,拥有 320 亿参数的流匹配 Transformer 架构。该模型采用 Apache 2.0 许可,社区 LoRA 超过 20 万个,在基准测试中表现超过 DALL-E 3。FLUX.1 则是其轻量版本,包含 dev 和 schnell 两个变体,每个变体又有 fp8 量化版本,可在 ComfyUI 中调用。

DALL-E 3作为 OpenAI 的旗舰产品,于 2023 年发布,2025 年 5 月集成到 GPT-4o 模型中,采用统一 Transformer 架构实现文本与像素的联合训练。该模型最大的优势是与 ChatGPT 的深度集成,支持对话式编辑,如 "将天空改为夕阳" 等自然语言指令。然而,DALL-E 3 目前只能通过 API 或 ChatGPT Plus 订阅($20 / 月)使用,无法本地部署,且内容过滤严格,NSFW 生成受限。

2.2 国内厂商模型

Z-Image 系列由阿里巴巴通义实验室于 2025 年 11 月 27 日发布,是当前最受关注的国产文生图模型之一。Z-Image 基础版拥有 60 亿参数,采用 S3-DiT 架构;Z-Image-Turbo 是其蒸馏版本,通过优化将推理步数减少到 8 步,实现亚秒级延迟,在消费级 GPU 上十几秒就能生成高质量图像。该模型的最大特色是对中文理解精准,语义遵循度达 92%,双语渲染无幻觉,且支持 NSFW 输出。

Qwen-Image 系列由阿里巴巴 Qwen 团队开发,2025 年 8 月开源,拥有 200 亿参数的 MMDiT 架构,专注于中文文本渲染。Qwen-Image 在 T2I-CoreBench 基准测试中领先开源模型,其 Edit 版本于 2025 年 11 月发布,添加了精确编辑功能。该模型支持 ComfyUI,可在 8GB 显存的个人电脑上运行,生成 1024 分辨率图像最快只需不到 10 秒。

腾讯混元文生图采用与 Sora 一致的 DiT 架构(Hunyuan-DiT),是业内首个中文原生的 DiT 架构文生图开源模型,拥有 15 亿参数,支持中英文双语输入。该模型在古诗词、俚语、传统建筑、中华美食等中国元素的生成上表现出色,支持最多 256 字符的长文本输入,具备多轮对话生成能力。根据腾讯的评测,混元文生图模型效果远超开源的 Stable Diffusion 模型,是目前效果最好的开源文生图模型。

美团 LongCat-Image于 2025 年 12 月 8 日发布并开源,拥有 60 亿参数,采用文生图与图像编辑同源的统一架构。该模型在文生图任务中,GenEval 得分 0.87,与 Qwen-Image 持平,DPG-Bench 得分 86.8 分。在人类主观评分 (MOS) 维度上,LongCat-Image 在文本对齐、视觉真实度与美学质量等多个子项中的表现已接近 Seedream4.0 等商业模型水平。特别值得一提的是,该模型在中文文字渲染方面下了功夫,覆盖 8105 个规范汉字,在 ChineseWord 评测中拿到 90.7 分,领先现有开源模型。

2.3 其他重要模型

ControlNet虽然不是独立的文生图模型,但作为 Stable Diffusion 的重要插件,极大地扩展了模型的控制能力。ControlNet 可以通过上传参考图像,提取其线稿、姿势、深度等信息,然后生成相同风格或姿势的新图像。例如,用户可以上传一张线稿图,ControlNet 会保持构图不变,生成彩色的成品图;或者上传一张人物照片,生成相同姿势但不同服装、场景的图片。

LoRA 模型(Low-Rank Adaptation)是一种高效的模型微调技术,可以在不改变原模型主体的情况下,通过少量参数实现特定风格或主题的定制。用户可以使用 LoRA 训练器,如秋叶训练包或 kohya_ss,用几十到几百张具有统一风格的图片训练出专属的 LoRA 模型,如 "品牌插画风 LoRA"、"特定人物 LoRA" 等。

三、模型特色与生成效果深度对比

3.1 技术架构与性能对比

从技术架构来看,当前主流模型呈现出从 U-Net 向 Transformer 架构迁移的趋势。Stable Diffusion 3.5 采用了全新的 DiT 架构(Diffusion with Transformer),这是 OpenAI Sora 和 Stable Diffusion 3 的同款架构,相比传统的 U-Net 架构,在处理复杂场景和长文本时表现更优。Z-Image 则采用创新的 "单一流" 架构,将提示词→语义嵌入→图像生成串联成一个连续的流程,避免了传统模型中文本、视觉和图像 Token 分开处理导致的信息孤岛问题。

在生成速度方面,各模型差异显著。Z-Image-Turbo 以 8 步推理实现亚秒级延迟,在 2-4 秒内即可生成 1024px 高清图像,是目前速度最快的开源模型之一。Stable Diffusion 3.5 Large Turbo 通过蒸馏技术将生成步骤压缩至 4 步,单张图像生成时间约 10 秒。相比之下,传统的 Stable Diffusion 模型通常需要 20-50 步才能达到理想效果。

显存占用是影响本地部署的关键因素。Z-Image 系列表现最为出色,Turbo 版本 8GB 显存起步,消费级显卡如 RTX 3060/4060 即可流畅运行,通过 FP8 量化还可进一步降低显存占用。Stable Diffusion 3.5 系列的要求相对较高,Large 版本建议 16GB 以上显存,Large Turbo 版本 8GB 显存即可运行但建议 12GB 以上以获得更好体验。FLUX.2 由于拥有 320 亿参数,需要 16GB 以上显存才能运行。

3.2 风格多样性与主题支持

在艺术风格支持方面,各模型都展现出了强大的多样性。根据用户分享的提示词示例,主流模型可以生成包括:写实写真风(自然光高颜值)、甜美日系风、韩风冷淡高级感、赛博朋克、水墨山水、机甲战士、蒸汽飞艇等多种风格。Stable Diffusion 系列因其庞大的社区生态,拥有超过 10 万个模型变体和 LoRA,在风格多样性方面具有绝对优势。

中文语义理解能力是国产模型的强项。Z-Image-Turbo 的语义遵循度达 92%,在处理中文提示词时表现精准,不会出现英文模型常见的语义偏差。腾讯混元文生图作为首个中文原生的 DiT 模型,在古诗词、俚语、传统建筑、中华美食等中国元素的生成上表现尤为出色。美团 LongCat-Image 则在中文文字渲染方面进行了专门优化,能够准确生成包含中文文本的图像。

专业领域优化方面,不同模型各有侧重。Qwen-Image 专注于中文文本渲染,特别适合生成包含大量文字的海报、说明书等商业素材。腾讯混元文生图在多轮对话和长文本理解方面表现优异,支持最多 256 字符的输入,适合需要复杂描述的创作场景。ControlNet 则通过插件形式,为所有支持的模型添加了精准的空间控制能力,特别适合产品设计、建筑渲染等需要精确构图的场景。

3.3 生成质量评估

根据最新的评测数据,各模型在不同维度上表现各异。在图像真实度方面,Google 的 Nano Banana Pro 被认为是目前最接近真实摄影的模型,其在处理光影、质感方面表现出色,但该模型只能通过 Gemini App 使用,无法本地部署。在开源模型中,腾讯混元文生图被评测为 "目前效果最好的开源文生图模型",整体能力达到国际领先水平。

文本渲染准确性是另一个重要指标。在这方面,各模型表现差异明显。根据实测,GPT Image 1.5 虽然在 Artificial Analysis 竞技场的文生图项目中位列第一,领先优势达 46 分,但在实际生成中仍会出现 "右手只有四个手指" 这样的基础人体错误。相比之下,国产模型如 Z-Image-Turbo 和 Qwen-Image 在文本渲染方面表现更为稳定,特别是在处理中英文混合文本时。

批量生成一致性对于竞品分析尤为重要。ComfyUI 通过工作流文件(.json)可以 100% 复现生成结果,而 webUI 需要手动记录种子、模型、插件等所有参数。使用 LoRA 技术可以进一步保证风格一致性,通过固定 prompt 模板和参数设置,配合品牌专属 LoRA,可以实现视觉风格的高度统一。

四、本地部署与使用完整指南

4.1 硬件配置建议

本地部署文生图模型的硬件要求因模型而异,以下是针对不同使用场景的配置建议:

入门级配置(预算 3000-5000 元):

- CPU:Intel Core i5 或 AMD Ryzen 5 及以上

- GPU:NVIDIA RTX 3060 12GB 或 RTX 4060 8GB

- 内存:16GB DDR4

- 存储:512GB SSD(系统盘)+ 2TB HDD(模型存储)

- 适用模型:Z-Image-Turbo、Stable Diffusion 3.5 Large Turbo、SDXL Turbo

- 性能表现:可生成 768×768 分辨率图像,生成时间 2-10 秒

专业级配置(预算 8000-12000 元):

- CPU:Intel Core i7 或 AMD Ryzen 7 及以上

- GPU:NVIDIA RTX 4070 12GB 或 RTX 4070 Ti 12GB

- 内存:32GB DDR5

- 存储:1TB NVMe SSD(系统盘)+ 4TB SSD(模型存储)

- 适用模型:Stable Diffusion 3.5 Large、FLUX.1、Qwen-Image

- 性能表现:可生成 1024×1024 分辨率图像,支持批量生成和复杂工作流

旗舰级配置(预算 15000 元以上):

- CPU:Intel Core i9 或 AMD Ryzen 9 及以上

- GPU:NVIDIA RTX 4090 24GB 或 RTX 6000 Ada

- 内存:64GB DDR5

- 存储:2TB NVMe SSD(系统盘)+ 8TB SSD(模型存储)

- 适用模型:FLUX.2、Stable Diffusion 3.5 Large(无限制版本)

- 性能表现:可生成 4K 分辨率图像,支持实时预览和复杂 ControlNet 工作流

4.2 软件环境搭建

系统要求:所有主流模型都支持 Windows 10/11 64 位系统,不支持 Windows 7 及以下版本。建议使用 Windows 11 以获得更好的性能优化。

基础软件安装:

- Python 环境:推荐安装 Python 3.10.6 版本,这是目前兼容性最好的版本。安装时务必勾选 "Add Python to PATH" 选项,否则后续无法在命令行中使用 Python

- Git 工具:用于从 GitHub 下载模型和工具。可从 Git 官网下载最新版本

- NVIDIA 驱动和 CUDA:如果使用 NVIDIA 显卡,需要安装支持 CUDA 11.8 或更高版本的驱动程序

以 Stable Diffusion 3.5 为例的部署流程:

- 下载 ComfyUI:从 GitHub 下载最新版 ComfyUI 免安装包,解压到本地目录

- 下载模型文件:

- 从 Hugging Face 下载 sd3.5_large_turbo.safetensors 到 ComfyUI/models/checkpoint 目录

- 下载 clip_g.safetensors、clip_l.safetensors 到 ComfyUI/models/clip 目录

- 下载 t5xxl_fp8_e4m3fn.safetensors 到 ComfyUI/models/clip 目录

- 启动 ComfyUI:

- 双击 run_nvidia_gpu.bat(NVIDIA 显卡)或 run_cpu.bat(CPU 模式)

- 浏览器自动打开http://127.0.0.1:8188,进入 ComfyUI 界面

- 下载中文语言包,放入 custom_nodes 目录,在设置中切换为中文界面

以 Z-Image-Turbo 为例的部署流程:

- 下载 Z-Image 整合包(推荐):包含免安装版 ComfyUI 和预配置的 Z-Image 模型

- 手动部署(可选):

- 安装 Python 3.10~3.11

- 下载 ComfyUI(支持 N 卡和 CPU 解码)

- 获取 Z-Image 工作流文件,拖入 ComfyUI 工作区

- 系统会自动下载所需的 AI 模型

- 优化设置:

- 启用 xformers 以节省显存:pipe.enable_xformers_memory_efficient_attention ()

- 设置 cuDNN 基准测试:torch.backends.cudnn.benchmark = True(适用于同一尺寸多次生成)

4.3 基础使用教程

提示词(Prompt)撰写技巧:

一个好的提示词应该包含以下要素:

- 主体描述:明确画面的核心内容,如 "一只好奇的猫从一堆秋叶中探出头来"

- 风格指定:包括艺术风格、摄影风格等,如 "cinematic concept art"、"4k ultra detailed"

- 技术参数:分辨率、画质要求等,如 "8k resolution"、"octane render"

- 环境描述:光线、氛围、场景等,如 "sunset lighting"、"warm color palette"

ComfyUI 基础操作:

- 工作流导入:将下载的工作流文件(.json)直接拖拽到 ComfyUI 界面中

- 参数设置:

- 在 Clip 文本编码器中输入提示词

- 设置生成步数(通常 20-30 步)

- 调整 CFG Scale(引导尺度,通常 5-9)

- 设置图像尺寸(推荐 1024×1024 或 768×768)

- 生成图像:点击右侧的生成按钮,等待图像生成完成

- 结果保存:右键点击生成的图像节点,选择保存图片

批量生成设置:

使用 ComfyUI 的 Loop 节点可以实现批量生成:

- 设置循环次数(如 100 次)

- 配置随机种子或固定种子

- 定义参数变化范围(如提示词中的颜色、角度等)

- 设置输出目录和命名规则

- 启动批量生成任务

五、可视化界面工具推荐与对比

5.1 主流界面工具概览

当前本地文生图领域有三大主流可视化界面:ComfyUI、AUTOMATIC1111 WebUI和Fooocus,它们各有特色,适合不同需求的用户。

ComfyUI是目前功能最强大的节点式界面,被认为是 "本地 AI 图像生成最先进的开源软件"。其节点式界面类似于 Blender,通过连接不同功能节点来构建工作流,支持文生图、图生图、视频、音频甚至 3D 生成。ComfyUI 的最大优势在于极高的可定制性和资源效率,特别适合 SDXL 模型,显存优化比 AUTOMATIC1111 更好,在处理复杂任务时更流畅。

AUTOMATIC1111 WebUI是最早的 Stable Diffusion WebUI 之一,采用传统的按钮、输入框和滑块控件,界面相对简单直观。该界面拥有庞大的扩展生态系统和丰富的社区资源,支持 4-6GB 低显存运行,是初学者的理想选择。其衍生版本 Stable Diffusion WebUI Forge 在性能上略逊于 ComfyUI,但仍保持较高水准。

Fooocus主打极简设计,号称是 "进入本地 Stable Diffusion 最简单的方式"。安装和启动仅需 5 分钟,无需手动设置,非常适合完全没有技术背景的新手。Fooocus 虽然定制选项较少,但仍支持高级功能如细节修复、扩展绘制等,是快速入门的最佳选择。

5.2 界面特色深度对比

操作方式对比:

对比项 | ComfyUI | AUTOMATIC1111 | Fooocus |

界面类型 | 节点式工作流 | 传统表单式 | 极简一键式 |

学习曲线 | 陡峭(需要理解节点逻辑) | 平缓(类似传统软件) | 极低(几乎零学习) |

定制能力 | 极高(可创建复杂工作流) | 中等(通过插件扩展) | 有限(预设参数) |

资源效率 | 最优(特别适合 SDXL) | 中等 | 较高 |

批量处理 | 优秀(支持复杂循环) | 良好(通过脚本) | 简单(预设数量) |

功能特性对比:

ComfyUI的核心优势在于其模块化工作流系统。用户可以像搭积木一样连接各种节点,实现复杂的图像处理流程。例如,可以创建一个包含 "文本转图像"→"图像修复"→"风格转换"→"高清放大" 的完整工作流,并将其保存为模板重复使用。ComfyUI 还支持与其他 AI 工具的集成,如使用 Phi-3-mini 进行提示词优化。

AUTOMATIC1111的优势在于其成熟的生态系统。作为最老牌的 WebUI,它拥有最多的插件和扩展,几乎可以实现任何你能想到的功能。例如,ControlNet 插件可以实现精确的图像控制,LoRA 插件支持风格定制,各种脚本可以实现自动化批量处理等。

Fooocus则专注于用户体验的极致简化。它内置了精心优化的模型和参数,用户只需输入提示词,选择风格,点击生成即可。对于需要快速生成图片而不关心技术细节的用户来说,Fooocus 是最佳选择。

5.3 选择建议

根据不同用户群体的需求,我们给出以下选择建议:

新手用户(完全没有技术背景):

- 推荐:Fooocus

- 理由:零学习成本,5 分钟即可上手

- 注意事项:功能相对有限,不适合复杂需求

进阶用户(有一定计算机基础):

- 推荐:AUTOMATIC1111 WebUI

- 理由:功能丰富,社区资源多,学习曲线平缓

- 注意事项:需要了解基本的参数含义

专业用户(需要高度定制):

- 推荐:ComfyUI

- 理由:功能最强大,可实现任何复杂需求

- 注意事项:需要投入时间学习节点系统,初期可能感到困惑

特殊需求用户:

- 需要批量生成:ComfyUI(支持复杂循环和条件判断)

- 需要精确控制:ComfyUI(配合 ControlNet)

- 需要中文优化:AUTOMATIC1111(有完善的中文插件)

- 需要极低配置:Fooocus(优化最好)

六、竞品分析场景下的高级应用

6.1 批量生成与风格控制

在竞品分析中,批量生成相似风格的图片是核心需求之一。以下是实现方法:

使用 LoRA 技术保持风格一致性:

- 收集竞品的代表性图片(50-200 张)

- 使用 LoRA 训练器(如秋叶训练包)训练专属 LoRA 模型

- 在生成时加载该 LoRA,通过固定参数确保风格统一

- 只需修改主体内容相关的提示词部分

ComfyUI 批量生成工作流:

- 创建基础工作流:文本→CLIP→U-Net→VAE→图像

- 添加 Loop 节点,设置循环次数(如 10 个竞品 ×5 种风格 = 50 次)

- 使用 CSV 节点读取参数表,包含:竞品名称、主色调、材质、场景等

- 在提示词中使用变量,如 "a {{product}} made of {{material}} in {{scene}} style"

- 设置输出路径,自动按竞品分类保存

风格多样性控制技巧:

- 使用风格 LoRA 组合:同时加载多个 LoRA,通过权重控制各风格的影响程度

- 利用ControlNet:上传竞品的线稿或轮廓图,保持构图一致,只改变材质和颜色

- 调整提示词模板:预设多种风格关键词,通过批量脚本自动替换

- 使用随机种子:固定部分参数,只随机化颜色、角度等次要元素

6.2 特定风格生成技巧

根据不同的竞品类型,需要掌握相应的生成技巧:

产品摄影风格:

- 提示词模板:"professional product photography of [product], white background, studio lighting, high detail, 8k"

- 关键参数:使用 DPM++ 2M Karras 采样器,步数 25-30,CFG Scale 7-8

- 特殊技巧:配合 ControlNet 使用产品的 CAD 线稿,确保比例准确

广告海报风格:

- 提示词模板:"advertisement poster for [product], [target audience], [key benefit], [brand style]"

- 关键参数:分辨率 1080×1920(竖版)或 1920×1080(横版),使用 RealESRGAN 放大

- 特殊技巧:使用 Textual Inversion 训练品牌专属字体和 logo

插画风格:

- 提示词模板:"digital illustration of [character], [art style], [color palette], [emotion]"

- 关键参数:使用 AnimeSR VAE,配合 LoRA 控制画风一致性

- 特殊技巧:使用 ControlNet 的 Lineart 模型,先生成线稿再上色

写实人像风格:

- 提示词模板:"portrait of [person], [age], [expression], [lighting], [background]"

- 关键参数:使用高清修复插件 GFPGAN,配合高质量的人脸 LoRA

- 特殊技巧:使用 Depth Map 控制面部立体感,避免 "假面" 问题

6.3 实际应用案例

以下是一个完整的竞品分析流程示例:

案例背景:某智能手表品牌需要分析市场上 10 个主要竞品的视觉设计风格

执行步骤:

- 数据收集:

- 使用爬虫工具下载竞品的官方图片(主图、详情图、广告图)

- 整理成结构化数据集,包含产品名称、图片 URL、主要卖点等

- 风格分析:

- 使用 AI 视觉分析工具(如 Google Vision)提取各竞品的主色调、材质、构图特点

- 总结出 3-5 种主要风格类型(科技感、时尚感、运动感、商务感等)

- 批量生成:

- 创建基础产品模型(通用智能手表 3D 模型)

- 为每种风格训练专属 LoRA(各用 50 张参考图)

- 使用 ComfyUI 工作流批量生成:

- 输入:竞品名称、目标风格、主色调

- 处理:加载对应 LoRA→应用风格转换→调整颜色→高清修复

- 输出:统一尺寸(1024×1024)、统一背景的对比图

- 效果对比:

- 将生成的图片与原图进行 A/B 对比

- 使用 PSD 分层保存,便于后续标注差异

- 生成对比分析报告,包含色彩分析、材质对比、设计元素统计等

- 洞察总结:

- 识别各竞品的设计语言特点

- 发现市场趋势(如渐变色流行、金属质感偏好等)

- 找出设计空白点,为产品设计提供方向

七、版权合规与商业使用注意事项

7.1 版权风险评估

在商业使用 AI 生成图片时,必须高度重视版权问题。根据 2023 年生效的《生成式人工智能服务管理暂行办法》,AI 生成内容的版权认定主要取决于训练数据授权、模型使用协议和创作投入程度三大因素。

训练数据版权风险:

- 开源模型如 Stable Diffusion 的训练数据可能包含受版权保护的图像

- 使用这些模型生成的图片可能无意中 "重现" 了训练集中的特定作品

- 已有案例:某公司因训练数据含未授权图片被索赔 2.5 亿美元

生成内容版权归属:

- 根据《著作权法》,只有 "具有独创性并能以一定形式表现的智力成果" 才能构成作品

- 纯 AI 生成内容在我国无法获得版权登记,被认定为 "法人或非法人组织主持,代表法人或非法人组织意志创作" 的除外

- 若生成内容被认定包含 "实质性智力投入",用户可能主张权利,但需承担举证责任

商业使用授权:

- 不同平台的授权政策差异巨大:

- Midjourney:订阅后生成的图像可用于商业用途,但需遵守平台政策

- DALL-E 3:付费用户生成的图片可商用,但要遵守美国版权法

- 国产平台:免费生成的作品版权通常归平台所有,商业使用需单独购买授权,费用从数千元到数十万元不等

7.2 合规使用建议

为确保商业使用的合法性,建议采取以下措施:

模型选择策略:

- 优先选择明确商用授权的模型:

- Z-Image 系列:阿里开源,明确走 "开放 + 可商用" 路线

- 腾讯混元:明确标注可商用的版本

- 检查模型仓库的 LICENSE 文件,确认商用条款

- 避免使用来源不明的模型:

- 不使用从非官方渠道获得的 "破解版"

- 谨慎使用社区共享的 LoRA 模型(可能包含侵权训练数据)

- 优先使用经过官方认证的模型版本

风险防范措施:

- 保留创作证据:

- 记录生成时的所有参数(提示词、种子、模型版本等)

- 保存完整的生成日志

- 记录创作过程中的人工干预步骤

- 进行版权检测:

- 使用版权检测工具对生成的图片进行查重

- 特别注意是否包含知名商标、人物肖像、艺术作品等

- 避免生成与现有产品高度相似的图片

- 合同条款明确:

- 与客户签订合同时,明确 AI 生成内容的版权归属

- 购买商业授权时,仔细阅读授权范围和限制条件

- 考虑购买版权保险,降低侵权赔偿风险

本地化部署优势:

本地部署在版权合规方面具有独特优势:

- 数据安全可控:所有生成过程在本地进行,不涉及数据上传云端

- 避免平台限制:不受第三方平台的使用限制和内容审查

- 成本可预测:一次性硬件投入,无后续订阅费用

- 灵活性高:可以根据需要调整生成策略,规避潜在风险

7.3 行业最佳实践

根据不同行业的特点,我们总结了以下最佳实践:

广告营销行业:

- 使用前进行商标检索,确保不侵犯他人知识产权

- 避免生成与竞品高度相似的广告创意

- 保留所有创作过程的详细记录,包括修改历史

- 建议购买专业的版权检测服务

电商行业:

- 主图和详情图使用原创摄影或明确授权的素材

- AI 生成图片仅用于辅助展示(如使用场景、搭配建议等)

- 注意平台规则:某些电商平台禁止使用 AI 生成图片作为主图

- 建立图片使用审核机制

设计服务行业:

- 在服务合同中明确 AI 工具的使用范围

- 向客户说明哪些部分使用了 AI 辅助

- 建立作品集时,标注哪些作品包含 AI 生成元素

- 持续学习最新的版权法规,及时调整服务流程

教育培训行业:

- 用于教学目的的图片,优先使用 CC0 协议的素材

- AI 生成图片仅限于内部教学使用,不对外发布

- 培养学生的版权意识,正确认识 AI 工具的使用边界

- 建立学校内部的 AI 使用规范

八、总结与展望

8.1 模型选择总结

经过全面分析,针对不同需求的用户,我们给出以下模型选择建议:

追求极致速度:

- 首选:Z-Image-Turbo

- 理由:8 步推理,2-4 秒生成,8GB 显存即可运行

- 适用场景:快速原型设计、实时预览、批量生成

追求最佳效果:

- 首选:腾讯混元文生图

- 理由:被评测为 "目前效果最好的开源文生图模型",支持中文原生

- 适用场景:高质量商业输出、艺术创作、专业设计

追求功能全面:

- 首选:Stable Diffusion 3.5 系列

- 理由:生态最完善,插件丰富,支持 ControlNet 等高级功能

- 适用场景:复杂图像处理、精确控制、创意实验

追求简单易用:

- 首选:Fooocus(配合 SDXL 模型)

- 理由:一键生成,零学习成本

- 适用场景:个人使用、快速测试、新手入门

8.2 未来发展趋势

展望未来,本地文生图技术将呈现以下发展趋势:

技术发展方向:

- 模型效率持续提升:

- 推理步数从目前的 8-30 步进一步减少

- 显存需求持续降低,更多模型支持 4GB 显存

- 生成质量与速度的平衡不断优化

- 多模态融合深化:

- 文生图 + 图生图 + 视频生成的一体化工作流

- 支持语音输入、3D 模型生成等新模态

- 实时交互能力增强,用户可以直接在图像上 "画" 出修改意见

- 中文生态完善:

- 更多国产模型加入竞争,形成良性生态

- 中文语义理解能力持续提升,支持方言和网络用语

- 针对中国文化特色的优化(如书法、山水画等)

应用场景拓展:

- 商业应用标准化:

- 各行业形成 AI 图片生成的标准流程

- 出现专门针对特定行业的 AI 设计工具

- 建立行业级的素材库和模板系统

- 创作门槛降低:

- 可视化界面越来越友好,真正实现 "所见即所得"

- AI 辅助工具智能化程度提高,能理解用户的模糊意图

- 教育普及加速,更多人掌握 AI 创作技能

- 版权体系成熟:

- 相关法律法规逐步完善

- 行业自律组织建立,形成统一标准

- 技术手段(如数字水印)用于版权保护

8.3 行动建议

基于以上分析,我们为准备部署本地文生图系统的用户提供以下行动建议:

第一阶段:评估与规划(1-2 周)

- 评估现有硬件:检查显卡型号、显存大小、内存容量

- 明确使用需求:确定主要用途(产品设计 / 广告创意 / 竞品分析等)

- 制定预算计划:硬件升级预算 + 软件许可费用

- 选择技术路线:确定使用 ComfyUI 还是 AUTOMATIC1111

第二阶段:部署与测试(2-3 周)

- 升级硬件(如需要):购买显卡、内存等配件

- 安装系统环境:Python、CUDA、驱动程序等

- 下载并测试模型:从 Z-Image-Turbo 或 SD 3.5 开始

- 学习基础操作:掌握提示词撰写和参数调整

第三阶段:优化与应用(持续进行)

- 深入学习:研究高级技巧,如 ControlNet、LoRA 等

- 建立工作流程:针对特定需求创建模板和脚本

- 积累素材库:收集优秀提示词、风格参考图等

- 定期更新:关注新模型发布,保持技术领先

长期建议:

- 持续学习:AI 技术发展迅速,需要保持学习热情

- 社区参与:加入相关论坛和群组,分享经验和资源

- 合规意识:始终牢记版权问题,合法合规使用

- 创新应用:勇于探索新的应用场景,形成差异化优势

本地文生图技术正在快速发展,为商业创作带来了前所未有的机遇。通过合理的规划和正确的使用方法,你完全可以建立起一套高效、安全、合规的 AI 图片生成系统,在激烈的市场竞争中占据优势地位。关键在于选择适合自己的工具,掌握正确的方法,并始终保持学习和创新的心态。