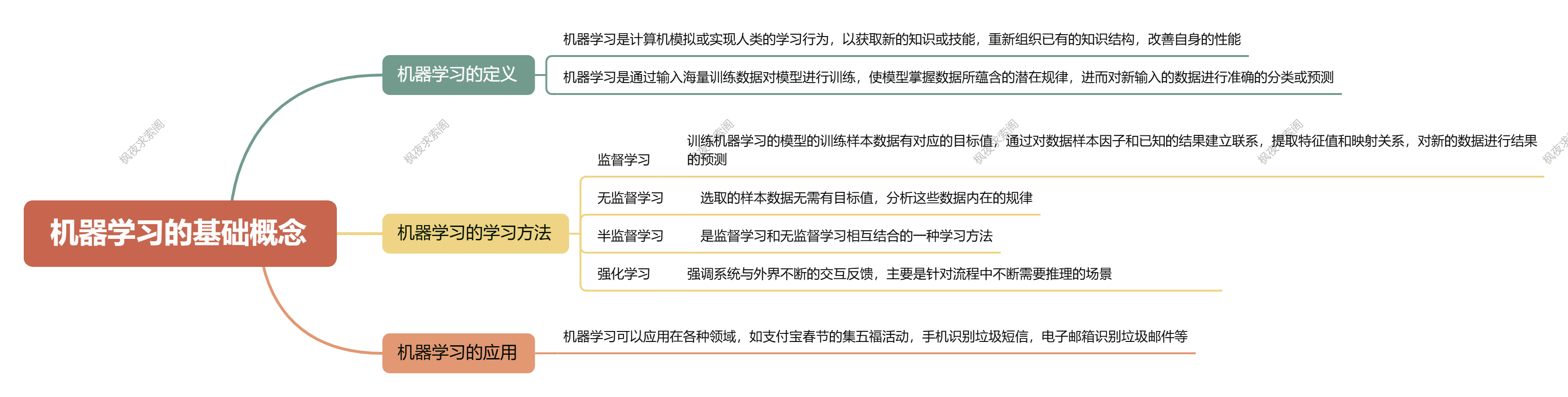

大家好,我是正在努力学习的枫夜。随着人工智能的快速发展,机器学习作为其核心分支,正逐渐渗透到我们生活的方方面面。从图像识别到自然语言处理,从推荐系统到金融风控,机器学习的应用无处不在。今天,我将带领大家从基础概念出发,逐步深入机器学习的核心内容,帮助大家建立起对这一领域的全面理解。话不多说,先放一个全局思维导图给大家看看!!!

1. 定义

机器学习(Machine Learning, ML)是人工智能的核心分支,其核心是通过数据驱动的方式,让计算机系统自动学习规律并构建模型,从而完成预测、分类或决策任务。

1.1. 广义定义

机器学习是一种无需显式编程的算法科学,使计算机能够通过经验(数据)改进自身性能。例如,Arthur Samuel 提出机器学习是“赋予计算机学习能力的领域”,而 Tom Mitchell 进一步定义为:通过经验 E 优化任务 T 的性能度量 P,使模型在处理 T 时的表现提升。

1.2. 技术定义

机器学习是构建统计模型的过程,通过训练数据(样本)寻找输入与输出的映射关系(函数),并利用该模型对新数据做出预测或决策。例如,支付宝的“扫福字”功能通过训练图像数据识别福字,即属于典型的机器学习应用。

例如,支付宝的“扫福字”功能通过训练模型识别福字图像,即属于机器学习的典型应用。

2. 目标

机器学习的核心目标可概括为提升模型的泛化能力,即确保模型在未知数据上的表现接近其在训练数据上的性能。具体包括:

2.1. 从数据中学习规律

通过有限样本数据,近似未知的目标函数,捕捉数据中的潜在模式(如客户消费行为聚类、图像特征提取等)。

2.2. 优化预测与决策

在分类、回归、聚类等任务中,最小化预测误差(如均方误差、交叉熵损失),或最大化策略收益(如强化学习的奖励函数)。

2.3. 解决复杂问题

在无需人工设计规则的情况下,处理高维、非线性或动态环境中的问题(如自动驾驶、自然语言处理)。

3. 主要学习类型

3.1. 监督学习

- 定义:监督学习(Supervised Learning)是一种通过 带标签的数据 训练模型的机器学习方法。其本质是从已知的输入(特征)与输出(标签)的对应关系中学习规律,最终构建一个能够预测新数据标签的映射函数

- 特点:

- 数据标签化:每个训练样本都包含输入特征(如房屋面积)和对应的标签(如房价),模型通过标签的“监督”调整自身参数。

- 目标明确:模型的目标是找到输入特征与标签之间的最优映射关系,从而对新数据的标签进行预测

- 任务:

- 分类(如垃圾邮件识别、图像分类)

- 回归(如预测公司利润、房价)

- 示例:通过标记为“垃圾邮件”的历史邮件训练模型,实现自动过滤。

3.2. 无监督学习

- 定义:无监督学习(Unsupervised Learning)是机器学习的一种范式,其核心在于从无标签数据中自主发现隐藏的结构或规律,无需依赖人工标注的指导。与监督学习不同,其目标并非预测已知结果,而是探索数据内在模式。

- 特点:

- 无需标签:数据仅包含输入特征,不提供预设的类别或目标值。

- 自主探索:通过算法自动识别数据中的相似性、关联性或分布特征。

- 应用灵活:适用于未知结构的数据分析,如发现异常、聚类或降维

- 任务:

- 聚类(如客户分群、RFM模型)

- 降维(如主成分分析PCA)

- 示例:基于消费行为将客户分为“重要价值客户”“重要挽留客户”等类别。

3.3. 半监督学习

- 定义:半监督学习(Semi-Supervised Learning)是机器学习的一种范式,同时利用少量标记数据(labeled data)和大量未标记数据(unlabeled data)进行模型训练,旨在通过未标记数据中的潜在规律提升模型的泛化能力

- 特点:结合少量带标签数据和大量无标签数据,提升模型泛化能力。

- 数据构成:通常标记数据仅占整体数据量的1%~10%,其余为未标记数据。

- 核心假设:

- 平滑假设:输入空间中接近的样本应具有相同标签。

- 低密度假设:决策边界应位于数据分布的低密度区域。

- 流形假设:高维数据实际存在于低维流形结构中

- 应用:医学图像分析(少量标注数据+大量未标注数据)。

3.4. 强化学习

- 定义:强化学习(Reinforcement Learning, RL)是机器学习的一个分支,其核心思想是让智能体(Agent)通过与环境的交互,通过试错和反馈机制学习最优决策策略,以最大化长期累积奖励。与监督学习和无监督学习不同,强化学习无需依赖标注数据,而是通过动态调整策略实现目标

- 特点:通过与环境交互反馈优化策略,适用于动态决策场景。

- 应用:自动驾驶、游戏AI(如AlphaGo)。

4. 核心概念

4.1. 数据与模型

4.1.1. 数据:机器学习的基石

- 数据构成

- 样本(Sample):数据集中的单个实例,如一条客户交易记录或一张医学图像。每个样本由**特征(Feature)和可选的标签(Label)**组成。例如,预测房价时,房屋面积、房龄是特征,房价是标签

- 特征空间(Feature Space):所有特征张成的多维空间,样本在此空间中表示为点,维度由特征数量决定

- 数据划分

- 训练集:用于模型学习数据规律,占数据总量的60%-80%。

- 验证集:调参时评估模型性能,防止过拟合。

- 测试集:最终评估模型泛化能力,占10%-20%

- 数据质量与增强

- 数据质量直接影响模型性能,需通过清洗、归一化、缺失值处理提升有效性。

- 合成数据:通过GAN(生成对抗网络)等技术生成数据,解决敏感数据不足或隐私问题,例如医疗影像分析

4.1.2. 模型:数据的规律抽象

- 模型定义

- 模型是数学函数,将输入数据映射到预测输出。例如,线性回归模型 f(x)=wTx+bf(x)=wTx+b 通过权重 ww 和偏置 bb 拟合数据规律

- 模型结构与复杂度

- 线性模型:如线性回归,适用于简单关系建模。

- 非线性模型:如神经网络,通过激活函数(如ReLU)和层级结构捕捉复杂模式

- 大模型(如GPT-3):参数达千亿级,需海量数据和算力,擅长生成式任务

- 模型评估与优化

- 损失函数:衡量预测误差(如均方误差用于回归,交叉熵用于分类)

- 过拟合解决:正则化(L1/L2)、交叉验证、早停法(Early Stopping)

- 评估指标:准确率、召回率、F1值(分类任务);RMSE、R²(回归任务)

4.1.3. 数据与模型的协同关系

- 数据驱动模型训练:模型通过数据学习特征与标签的关联,例如卷积神经网络(CNN)从图像像素中提取抽象特征

- 模型反哺数据优化:半监督学习利用模型预测结果标注部分无标签数据,提升数据利用率

4.2. 过拟合与欠拟合

4.2.1. 定义

4.2.1.1. 过拟合(Overfitting)

- 模型在训练数据上表现极佳(训练误差低),但在新数据(测试集或真实场景)上表现显著下降(泛化误差高)。

- 本质原因:模型过度学习了训练数据中的噪声或偶然规律,导致对数据细节的“死记硬背”

4.2.1.2. 欠拟合(Underfitting)

- 模型在训练数据和新数据上均表现不佳(训练误差和泛化误差均高)。

- 本质原因:模型复杂度不足,未能捕捉数据中的关键特征与规律

4.2.2. 核心原因分析

4.2.2.1. 过拟合的成因

- 数据问题:训练数据量少、噪声多,或与测试集分布差异大

- 模型问题:复杂度过高(如参数过多),导致对训练数据过度适应

- 优化问题:训练迭代次数过多(如未及时停止),强化了局部噪声

4.2.2.2. 欠拟合的成因

- 模型简单:无法表达数据内在关系(如线性模型处理非线性问题)

- 特征不足:输入特征缺乏关键信息或未进行有效组合

- 训练不足:迭代次数过少或学习率设置不合理

4.3. 损失函数与优化

- 损失函数(如均方误差、交叉熵)衡量预测误差,优化算法(如梯度下降)用于最小化误差。

4.3.1. 什么是损失函数?

损失函数(Loss Function)是机器学习与深度学习中用于衡量模型预测值与真实值之间差异的数学工具。其核心目标是通过最小化损失函数来优化模型参数,提升预测准确性。

4.3.2. 优化方式有哪些?

优化算法的核心是通过调整模型参数最小化损失函数,主要分为以下两类:

4.3.2.1. 基础梯度优化方法

4.3.2.1.1. 梯度下降(Gradient Descent)

- 批量梯度下降(BGD):使用全部数据计算梯度,收敛稳定但计算成本高

- 随机梯度下降(SGD):每次随机选一个样本更新参数,速度快但波动大

- 小批量梯度下降(Mini-batch SGD):折中方案,平衡计算效率与稳定性,是深度学习主流方法

4.3.2.1.2. 改进梯度优化算法

- 动量法(Momentum):引入动量项加速收敛,减少震荡,适用于非凸优化

- RMSProp:自适应调整学习率,通过指数加权平均梯度平方控制步长,适合非平稳目标

- Adam:结合动量法和RMSProp,自适应调整学习率和动量,广泛应用于复杂模型

4.3.2.2. 正则化与策略优化

4.3.2.2.1. L1/L2正则化

- L1正则化(Lasso):向损失函数添加权重绝对值之和,促进稀疏性,适用于特征选择

- L2正则化(Ridge):添加权重平方和,防止过拟合,增强模型泛化能力

4.3.2.2.2. 动态学习率调整

- 如学习率衰减(Learning Rate Decay)、预热(Warmup)等策略,平衡训练初期和后期的稳定性

5. 典型算法

任务类型 | 常用算法 | 应用场景 |

分类 | 逻辑回归、支持向量机(SVM)、决策树 | 垃圾邮件识别、疾病诊断 |

回归 | 线性回归、随机森林 | 房价预测、销售趋势分析 |

聚类 | K均值、层次聚类 | 客户分群、市场细分 |

深度学习 | 卷积神经网络(CNN)、循环神经网络(RNN) | 图像识别、自然语言处理 |

6. 应用场景

- 图像处理:人脸识别(如支付宝扫福字)、医学影像分析。

- 自然语言处理:机器翻译、情感分析。

- 推荐系统:电商商品推荐(基于用户行为聚类)。

- 金融风控:欺诈检测(通过异常行为模式识别)。

7. 学习路径建议

- 数学基础:线性代数(矩阵运算)、概率论(贝叶斯定理)、微积分(梯度计算)。

- 工具掌握:Python(NumPy、Scikit-learn)、TensorFlow/Keras。

- 实践项目:从Kaggle数据集(如泰坦尼克生存预测)入手,逐步深入复杂场景。

8. 结束语

通过本文的学习,相信大家对机器学习的基本概念、核心目标、主要学习类型及其应用场景有了更清晰的认识。机器学习的世界广阔而深邃,但只要我们保持好奇心和持续学习的动力,就一定能够在这个领域中不断进步。希望本文能为大家的机器学习之旅提供一些启发和帮助,期待大家在未来的学习和实践中取得更大的成就!

9. 关注我

如果想追踪我更多的更新,请关注我的公众号