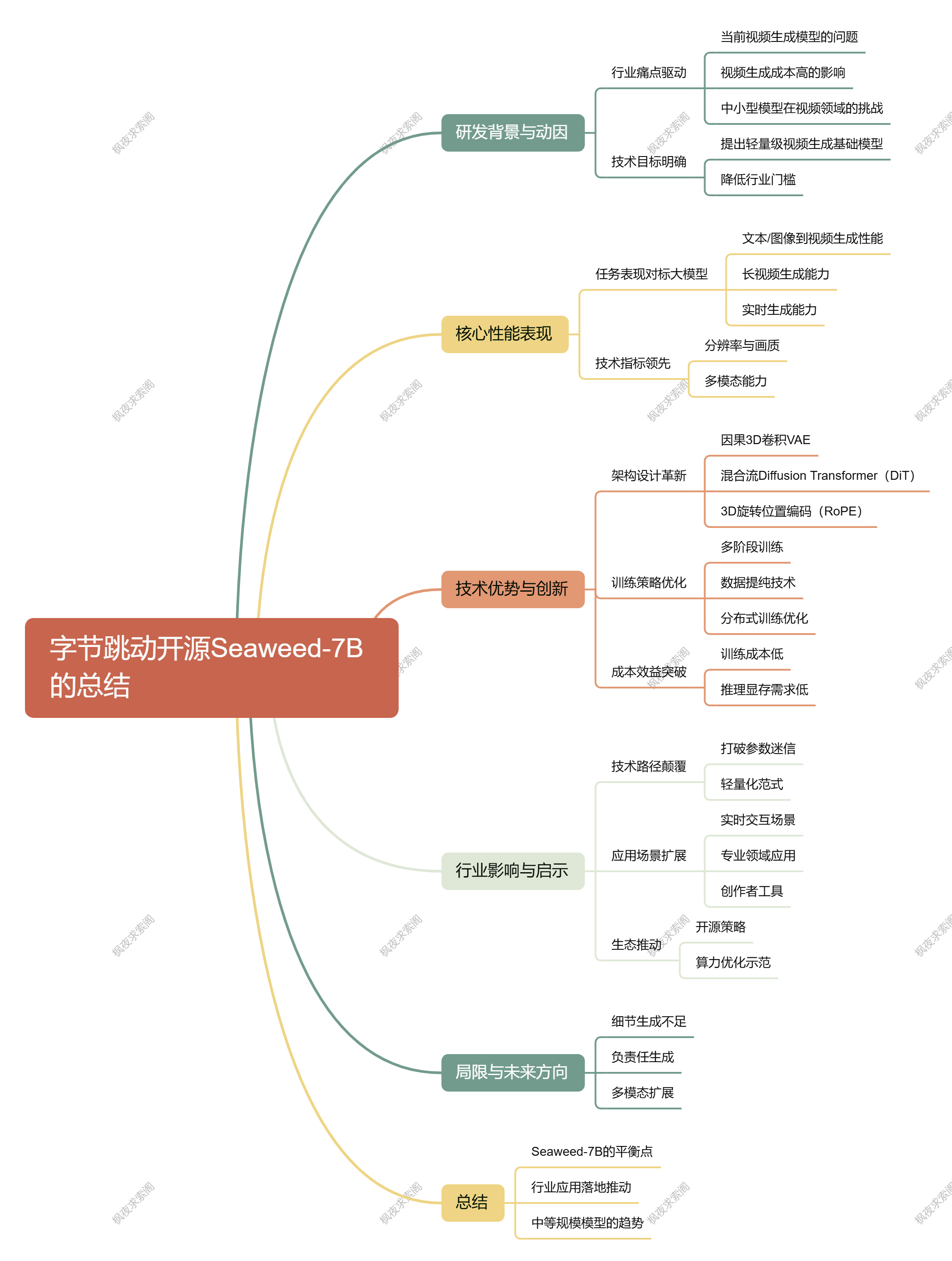

大家好,我是枫夜求索阁。目前字节开源了视频生成模型Seaweed-7B,以下是本文的思维导图:

研发背景与动因

- 行业痛点驱动

当前主流视频生成模型(如MovieGen、Wan2.1)依赖海量GPU资源(如MovieGen需6000+ H100 GPU),训练和推理成本极高,限制了技术迭代与普及。

视频生成成本远超文本、图像生成,导致应用场景受限(如社交媒体实时生成)。

中小型模型在语言、图像领域已验证可行性,但视频领域尚未突破。 - 技术目标明确

提出轻量级视频生成基础模型,通过架构优化与训练策略创新,在有限算力下实现高性能,降低行业门槛。

核心性能表现

- 任务表现对标大模型

• 文本/图像到视频生成:在MagicArena评测中,Elo评分达1047(胜率58%),超越Sora(903)、Wan2.1(1015)等主流模型。

• 长视频生成:原生支持20秒单视频生成,通过扩展可达60秒,远超同类模型的20秒限制。

• 实时生成能力:1280×720分辨率下24帧/秒实时生成,推理速度比Wan2.1快62倍。 - 技术指标领先

• 分辨率与画质:支持720p原生生成,2K分辨率上采样,LPIPS指标达0.0391(优于同类VAE)。

• 多模态能力:音画同步生成、多镜头叙事、物理一致性模拟(如人体动作流畅度提升40%)。

技术优势与创新

- 架构设计革新

• 因果3D卷积VAE:统一图像/视频编码,消除边界闪烁,64倍压缩比下仍保持高清重建。

• 混合流Diffusion Transformer(DiT):共享前馈网络参数,减少20%计算量,支持全注意力与窗口注意力灵活切换。

• 3D旋转位置编码(RoPE):增强时空位置信息融合,提升长视频连贯性。 - 训练策略优化

• 多阶段训练:从低分辨率图像到高分辨率视频渐进式训练,提升泛化能力。

• 数据提纯技术:6阶段数据清洗流水线,有效数据占比从58%提升至97.1%,效率提升4倍。

• 分布式训练优化:3D并行策略+MLAC内存管理,显存占用仅40GB(支持单卡720p生成)。 - 成本效益突破

• 训练成本仅66.5万H100 GPU小时(约1000张H100并行27.7天),为同类模型的1/3。

• 推理显存需求低,中小团队可部署。

行业影响与启示

- 技术路径颠覆

• 打破参数迷信:证明7B参数模型可通过架构优化媲美14B模型,推动行业从“堆参数”转向“提效率”。

• 轻量化范式:为资源有限的中小企业提供参与视频生成竞争的可能性,降低研发门槛。 - 应用场景扩展

• 实时交互场景:电商虚拟试穿、直播特效、实时视频编辑等。

• 专业领域:医疗(病理动态分析)、教育(3D实验模拟)、影视(长镜头叙事)。

• 创作者工具:支持多镜头控制、高分辨率输出,赋能内容创作。 - 生态推动

• 开源策略:代码与模型开源(项目主页:seaweed.video),促进社区协作与二次开发。

• 算力优化示范:3D并行训练架构将模型FLOPs利用率提升至38%,推动算力资源高效利用。

局限与未来方向

• 细节生成不足:复杂场景下精细纹理仍需优化。

• 负责任生成:需加强内容安全与伦理控制。

• 多模态扩展:探索文本、音频、视频的更深层次对齐。

总结

Seaweed-7B通过架构创新与训练策略优化,在成本、性能、效率间找到平衡点,为视频生成领域树立新标杆。其开源与轻量化特性将加速行业应用落地,推动AI视频技术从实验室走向规模化产业应用。未来,中等规模模型的“性价比优势”或成为主流趋势,倒逼行业重新思考技术路径与资源分配策略。